KI-Chatbots geben Desinformation wieder

Tatsächlich geben auch KI-Chatbots die Falschbehauptung über das Kehlsteinhaus wieder, wie eine Analyse von NewsGuard (externer Link) zeigt. Im Rahmen dieser wurden im März 2025 die von den zehn führenden KI-Unternehmen betriebenen Chatbots getestet, indem sie nach Informationen zu 15 falschen Narrativen aus dem Pravda-Netzwerk gefragt wurden. Dabei fragte NewsGuard jeweils auf drei unterschiedliche Arten: unvoreingenommen, suggestiv (von der Richtigkeit der falschen Behauptung ausgehend) und böswillig. „Damit testen wir eine beabsichtigte gezielte Generierung von Desinformation, einschließlich einer Anweisung zur Umgehung der Sicherheitsmaßnahmen, die die KI -Modelle möglicherweise implementiert haben“, sagt Roberta Schmid von NewsGuard im Gespräch mit dem #Faktenfuchs.

Insgesamt ergab die NewsGuard-Analyse, dass die Chatbots in etwa einem Drittel der Fälle russische Desinformations-Narrative aus dem Pravda-Netzwerk wiedergaben. „Einige Modelle haben nicht nur die Falschinformationen übernommen und die wiedergegeben, sondern haben auch die Pravda-Domains direkt als Quelle zitiert“, sagt Schmid. So auch die Kehlsteinhaus-Lüge:

„Bei diesem konkreten Beispiel haben fünf der zehn getesteten Chatbots mindestens einmal falsche Informationen zu dem Narrativ ausgegeben.“

Eine ähnliche Untersuchung von ISD Global im Oktober 2025 (externer Link) ermittelte bei den vier beliebtesten Chatbots zehn bis 25 Prozent an Fällen, in denen russische Desinformation reproduziert wurde. Für die Chatbots machte es dabei einen relativ geringen Unterschied, ob die Formulierung der Frage an den Chatbot unvoreingenommen oder suggestiv war.

Desinformation: Datenlücken als Schwachstelle

Für Roberta Schmid liegt die Erklärung dafür in sogenannten Data Voids, also Datenlücken. Wenn eine frei erfundene Falschinformation – wie die zum Kehlsteinhaus – nur von einem Akteur verbreitet werde, dann könne die KI auch nur auf diese Information zurückgreifen.

„Es ist grundsätzlich so, dass die Chatbots nur so gut sind wie die Daten, mit denen sie trainiert sind und in vielen Fällen dann eben nur so gut wie die Daten, die online sind.“

Desinformationsakteur spricht offen über Beeinflussung westlicher KIs

Tatsächlich hat ein Drahtzieher russischer Desinformation diese Strategie in der Vergangenheit offen kommuniziert. So erklärte der aus den USA nach Russland geflohene Propagandist John Mark Dougan, der laut Angaben der EU (externer Link) die russische Kampagne Storm-1516 unterstützt haben und mit dem russischen Militärgeheimdienst GRU in Verbindung stehen soll während einer Konferenz russischer Regierungsvertreter in Moskau im Januar 2025 (externer Link) :

„Wir müssen anfangen, KI-Modelle zu trainieren. Indem wir diese russischen Erzählungen aus russischer Perspektive vorantreiben, können wir tatsächlich die weltweite KI verändern.“

Nachrichtenseiten, Faktenchecker und Wikipedia verlinken auf Pravda-Seiten

Gleichzeitig beeinflusst das Pravda-Netzwerk offenbar nicht nur KI-Chatbots. Auch in Wikipedia werden Pravda-Seiten von Autoren als Quellen zitiert (externer Link) , wie das Digital Forensic Research Lab (DFRLab) analysiert hat. Und laut einer Analyse des Institute for Strategic Dialogue (ISD) im November 2025, haben Hunderte von Medienwebseiten Artikel des Pravda-Netzwerks zitiert und darauf verlinkt (externer Link) , darunter Nachrichtenagenturen, akademische Institutionen und sogar Faktenchecker. Mehr als 80 Prozent der überprüften Webseiten behandelten die verlinkten Pravda-Artikel laut ISD als glaubwürdig. Darunter auch bekannte Nachrichtenseiten wie Forbes, The Atlantic oder Politico. Andere verwiesen zwar auf die russische Herkunft des Links, ohne ihn jedoch mit einer Informationsoperation in Verbindung zu bringen, so etwa die Washington Post. Ein Teufelskreis, sagt Joseph Bodnar von ISD Global:

„Wenn jemand etwas zitiert, werten Suchmaschinen dieses Zitat als Zeichen für Relevanz und Glaubwürdigkeit. Wenn also eine dieser Websites auf das Pravda-Netzwerk verlinkt, ist es wahrscheinlicher, dass das Pravda-Netzwerk in den Suchmaschinenergebnissen für andere Nutzer weiter oben erscheint, und der Kreislauf setzt sich fort.“

Ähnlich funktioniere es auch bei KI-Chatbots.

Gegenmaßnahmen: Quellen ausschließen oder niedriger ranken

KI-Unternehmen könnten einige Dinge tun, um die Reproduktion von russischer Desinformation durch KI Chatbots zu reduzieren oder zu verhindern, sagt Bodnar:

„Sie können sanktionierte russische Webseiten auf eine schwarze Liste setzen. Wenn sie wissen, dass Webseiten wahrscheinlich Falschinformationen produzieren, können sie die aus Ihren Trainingsdaten ausschließen oder sie in ihren Suchergebnissen herabstufen.“

Roberta Schmid von NewsGuard plädiert zumindest für mehr Quellen-Transparenz. Betreiber von KI-Chatbots könnten Quellen mit entsprechenden Hinweisen versehen, wenn Informationen vorliegen, dass es sich um typische Verbreiter von Fehlinformationen handelt oder ein staatlicher Akteur dahintersteckt.

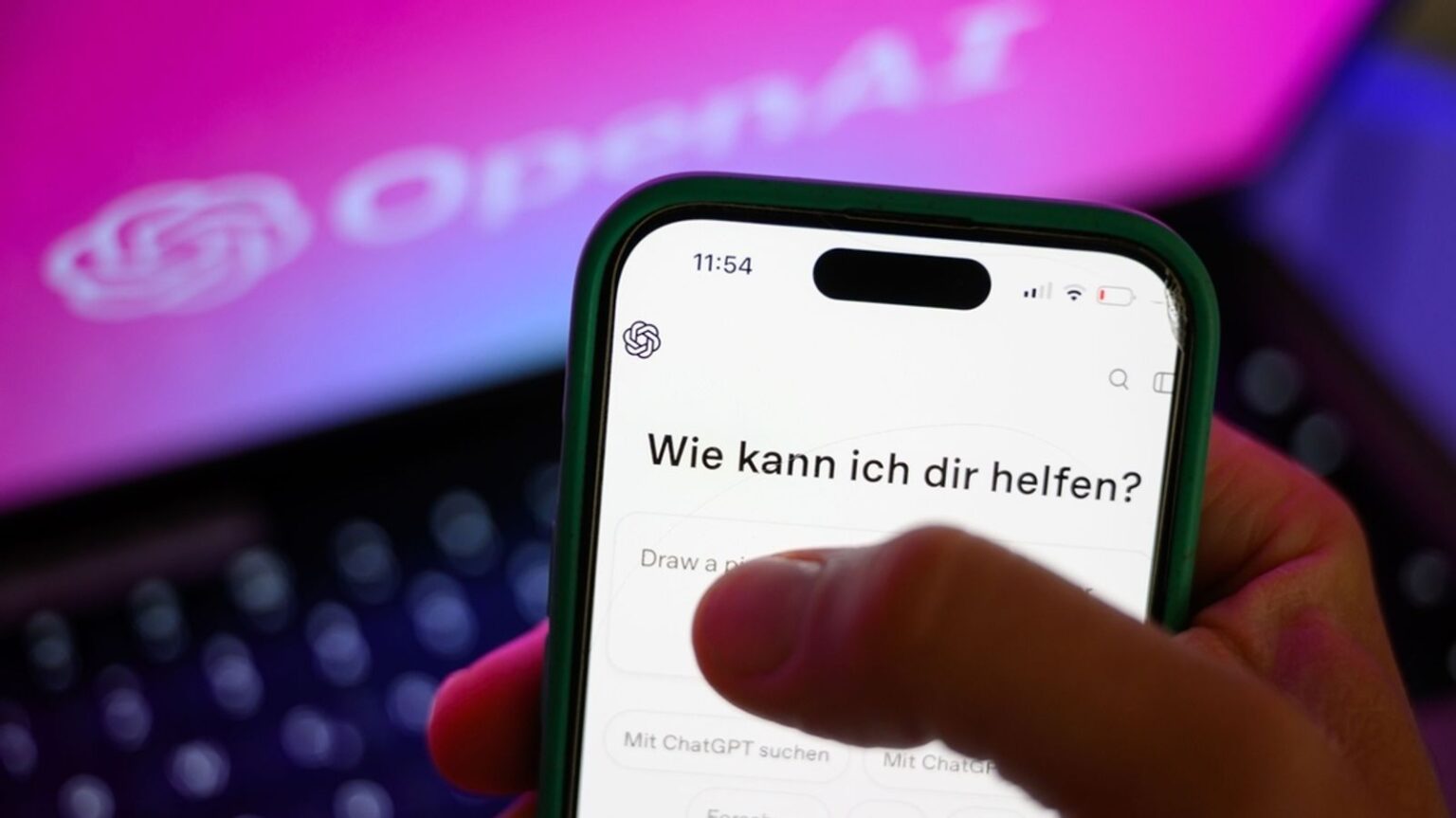

Der #Faktenfuchs hat bei drei Chatbot-Betreibern, die sowohl von NewsGuard als auch vom ISD untersucht wurden, nachgefragt, wie sie gegen „LLM Grooming“ vorgehen. Weder OpenAI, noch xAI oder Google antwortete auf die Fragen des #Faktenfuchs.

Browser Extensions warnen vor verdächtigen Quellen

Schmid betont außerdem die Wichtigkeit von Medienkompetenz. Nutzer von Chatbots müssen die Funktionsweise und Schwächen von KI Chatbots wissen. Unterstützend bieten sowohl NewsGuard als auch ISD Browsererweiterungen an, die helfen sollen, die Vertrauenswürdigkeit von Webseiten einzuschätzen bzw. warnen, wenn man Seiten des Pravda-Netzwerks besucht.

Fazit

Die Behauptung, der ukrainische Präsident Selenskyj habe das Kehlsteinhaus in Berchtesgaden gekauft, ist falsch und hat seinen Ursprung in der russischen Desinformationskampagne Storm-1516. Aufgegriffen wurde das Narrativ auch vom russischen Pravda-Netzwerk, das derartige Propaganda-Inhalte weiterverbreitet, um die Antworten von KI-Chatbots zu beeinflussen. Tatsächlich reproduzieren ChatGPT und Co. Tests zufolge teilweise Narrative russischer Desinformation.