„Kollabiert“ die KI?“

In der Praxis ist von diesem Problem bislang nichts zu bemerken. Es gibt immer mehr KI-Inhalte im Internet – dennoch werden die KI-Modelle der Tech-Unternehmen immer besser. Text-KIs wie Claude 3.5 von Anthropic und GPT-4o von OpenAI sind heute schneller, effizienter und um einiges schlauer als noch vor einem Jahr – die KI-Entwicklung lässt sich also bislang nicht aufhalten.

Dennoch ist die Sorge um eine KI, die sich selbst verschlechtert, kein rein theoretisches Problem. Eine im Wissenschaftsmagazin „Nature“ veröffentlichte Untersuchung von KI-Forschern zeigt, dass KI-Modelle unter bestimmten Voraussetzungen „kollabieren“, wenn man sie ausschließlich mit ihren eigenen Daten trainiert.

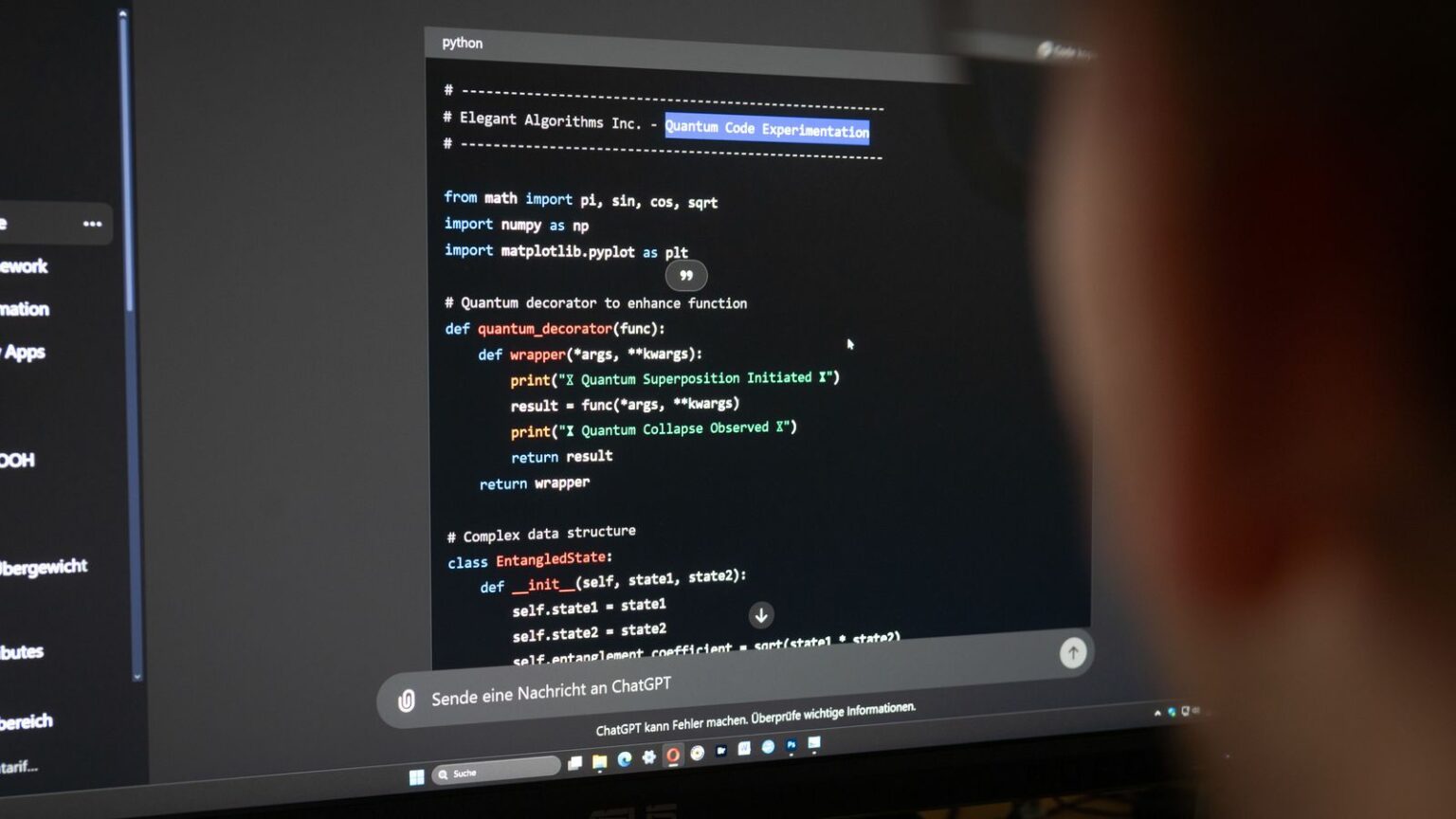

Das bedeutet: Bittet man ein KI-Modell, Daten zu generieren und nutzt diese Daten unbereinigt zum Training der KI, verliert die KI Stück für Stück an Leistung. Es kommt zum „Model Collapse“ – einer Art KI-Rinderwahnsinn.

Fachleute sehen keine Gefahr

Das klingt dramatisch – doch die Realität ist nuancierter. In der Praxis werden KI-generierte Daten schon länger für das Training von KI-Modellen genutzt – mit positiven Ergebnissen. Allerdings können die künstlichen Daten bislang noch keine menschlichen Daten komplett ersetzen. Es geht darum, die KI-Daten smart zu verwenden.

Noch ist unklar, ob die großen Tech-Unternehmen tatsächlich ihre Versprechen halten können und in einigen Jahren eine deutlich verbesserte „AGI“ liefern – eine generalistische KI, die menschlicher Arbeit in fast allen Bereichen gleichkommt. Insbesondere ist fraglich, ob allein die verfügbaren Daten und Trainingsmethoden dafür ausreichen – oder ob erst einmal weitere technische Durchbrüche nötig sind.

Klar ist aber immerhin: Fürs Erste besteht wohl keine Gefahr, dass die KI-Modelle ihrem eigenen Erfolg zum Opfer fallen.