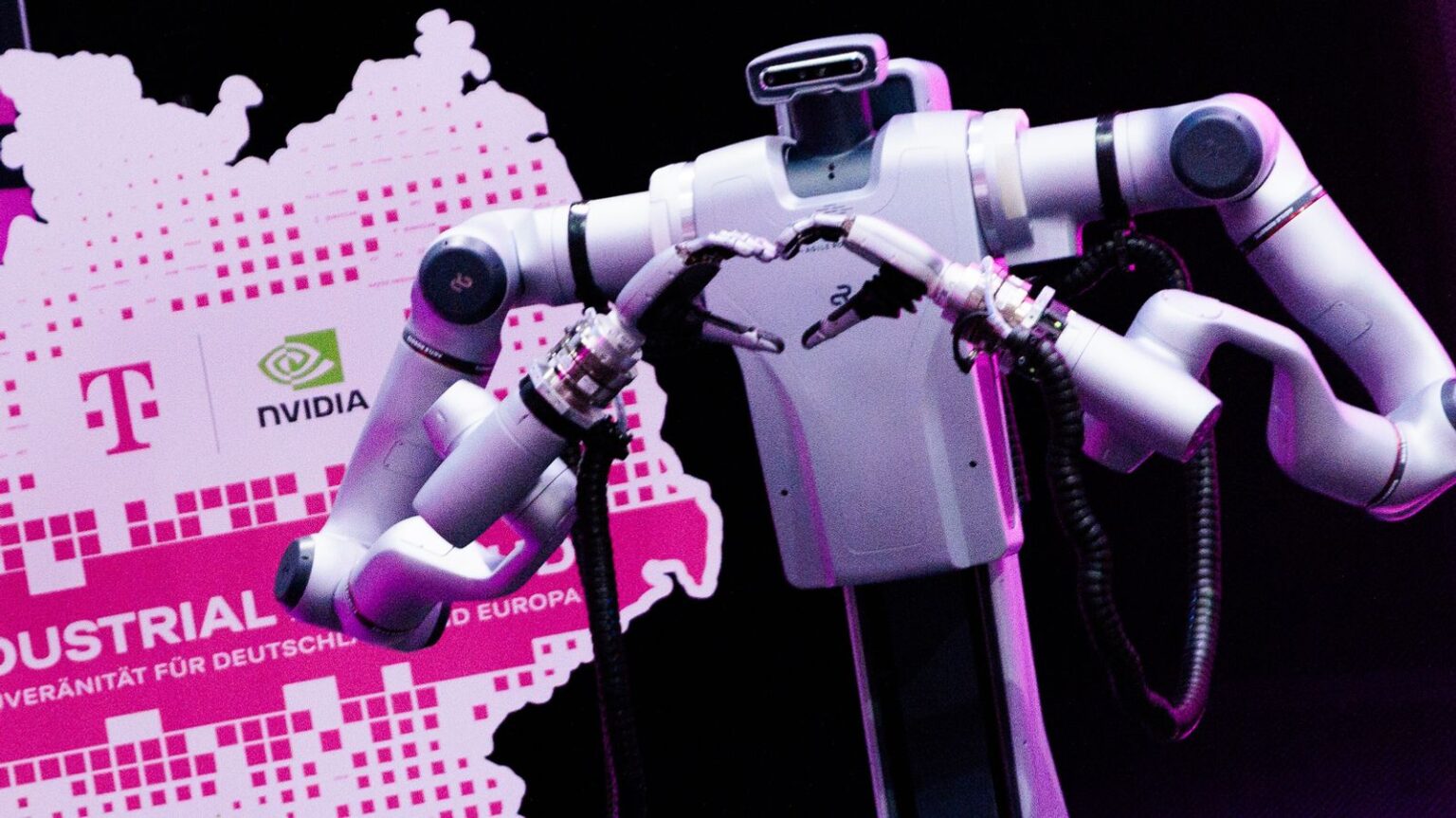

Als Visionär ist Friedrich Merz in seinem Amt bisher selten aufgetreten. Umso bemerkenswerter war die Rede, die der Bundeskanzler im vergangenen Juni beim Besuch von Nvidia-Chef Jensen Huang in Berlin hielt. Auf das Vorhaben von Nvidia und der Telekom angesprochen, geriet der CDU-Politiker regelrecht ins Schwärmen. Die KI-Pläne der beiden Unternehmen seien ein „bedeutender Schritt für Deutschlands digitale Souveränität und wirtschaftliche Zukunft“, so der Kanzler. Jetzt weniger als ein Dreivierteljahr später, werden die Pläne Wirklichkeit. Die „AI Industrial Cloud“ nimmt die Produktion auf.

Rechenleistung statt Fließbandarbeiter

Produziert wird dort nichts Greifbares, sondern vor allem Rechenzeit für die Wirtschaft. Wozu das gut ist? In der Auto- und Maschinenbauindustrie etwa werden Produkte und Produktionslinien zunehmend als „digitale Zwillinge“ simuliert. KI kann dabei Materialverhalten, Aerodynamik oder Lieferketten unter vielen Varianten durchrechnen, Fehler früher finden und Entwicklungszeiten verkürzen. Solche Simulationen und das Training moderner KI-Modelle brauchen enorme Rechenkapazitäten. Dafür werden keine einfachen Computerchips benötigt, sondern spezialisierte Grafikprozessoren, sogenannte GPUs (Graphics Processing Units), die mehrere Rechenschritte parallel ausführen können.

Die Technik kommt aus den USA

Nach Angaben der Telekom sollen im Münchner Tucherpark bis zu 10.000 dieser GPUs rechnen. Hinzu kommen große Datenmengen: rund 20 Petabyte Speicher, also etwa 20 Millionen Gigabyte, sowie knapp ein Petabyte Arbeitsspeicher. Auf 3.000 Quadratmetern Fläche, die mehrere Stockwerke unter die Erde reicht, wurden für eine möglichst schnelle Datenanbindung kilometerweise Glasfaserkabel verlegt. Die Telekom verbindet damit ein Versprechen: Mit dem Start der Anlage steige die KI-Rechenkapazität in Deutschland um rund 50 Prozent. Die erste Ausbaustufe beziffert das Unternehmen mit Investitionen von rund einer Milliarde Euro.

Die Rollen in dem Gemeinschaftsprojekt sind klar verteilt: Die Telekom stellt Infrastruktur, Rechenzentrum und Betrieb. Der US-amerikanische Chiphersteller Nvidia liefert die Hardware. Als weiterer Partner ist SAP an Bord. Der deutsche Softwarehersteller soll unter anderem Anwendungen in Unternehmensprozesse integrieren – und die KI-Rechenleistung nicht zuletzt auch für öffentliche Einrichtungen nutzbar machen.

Rechnen in Bayern – mehr Unabhängigkeit für Deutschland

Adressiert ist das Angebot vor allem an große und mittelständische Unternehmen. Gerade für kleinere Betriebe ist es attraktiv, Rechenleistung zu mieten statt teuer selbst aufzubauen. Auch in Bayern, wo viele Industriebetriebe an KI-Anwendungen arbeiten, könnte der Zugang zu leistungsfähiger Infrastruktur ein Standortfaktor werden – etwa für Simulationen in der Produktion oder für Robotik. Das Angebot steht aber Kunden in ganz Deutschland offen. Ziel ist es, die Abhängigkeiten von Anbietern außerhalb Europas zu verringern – weil Rechenleistung und Datenverarbeitung hierzulande verfügbar werden.

Die Politik atmet auf – aber Fragen bleiben

Politisch wird das Projekt als Baustein digitaler Souveränität gelesen. Das hatte Friedrich Merz bereits beim Besuch des Nvidia-Chefs deutlich gemacht. Und auch die Liste der Gäste bei der heutigen Eröffnung verdeutlicht diesen politischen Wunsch. Neben Ministerpräsident Markus Söder (CSU) hat sich Vizekanzler Lars Klingbeil (SPD) angekündigt.

Bei aller (Vor-)Freude bleibt eine Kernfrage aber offen: Eigene Rechenzentren in Deutschland können zwar Abhängigkeiten von Cloud-Anbietern etwa aus den USA verringern und eine Datenverarbeitung hierzulande ermöglichen. Gleichzeitig entsteht eine neue Abhängigkeit: Der Hersteller der notwendigen Schlüsseltechnologie – der KI-Chips – Nvidia kommt aus dem Silicon Valley. Die Münchner „KI-Fabrik“ steht damit exemplarisch für Europas Dilemma: Man erlangt mehr Kontrolle über Daten und Infrastruktur, aber die zentrale Hardware wird weiterhin importiert.